Apple ออกมายืนยันแล้วว่า ใน iOS 15 และ iPadOS 15 จะมีการเพิ่มระบบสำหรับตรวจจับวัตถุหรือภาพที่แสดงการล่วงละเมิดทางเพศเด็ก (CSAM) บนรูปภาพที่ถูกอัปโหลดเข้าสู่ iCloud ทั้งใน iPhone และ iPad โดยจะเริ่มใช้ก่อนในสหรัฐอเมริกา

โดยทางแอปเปิล จะมีระบบที่สามารถสแกนภาพที่กำลังถูกอัปโหลดขึ้นไปใน iCloud เพื่อตรวจสอบว่าเนื้อหาดังกล่าวมีการล่วงละเมิดทางเพศเด็กหรือเปล่า แต่ไม่สามารถสแกนภาพทั้งหมดที่ถูกอัปโหลดไปก่อนหน้าการอัปเดตในครั้งนี้ได้ ซึ่งแอปเปิ้ลกล่าวว่า CSAM มีความแม่นยำที่สูงมาก และมีโอกาสผิดพลาดเพียงหนึ่งในล้านล้านครั้งต่อปีเท่านั้น

หากมีการตรวจพบเนื้อหาที่ไม่เหมาะสมบัญชีผู้ใช้รายดังกล่าวจะถูกปิดใช้งานทันที และจะมีการแจ้งไปยังศูนย์เพื่อเด็กหายและถูกฉวยผลประโยชน์แห่งชาติด้วย

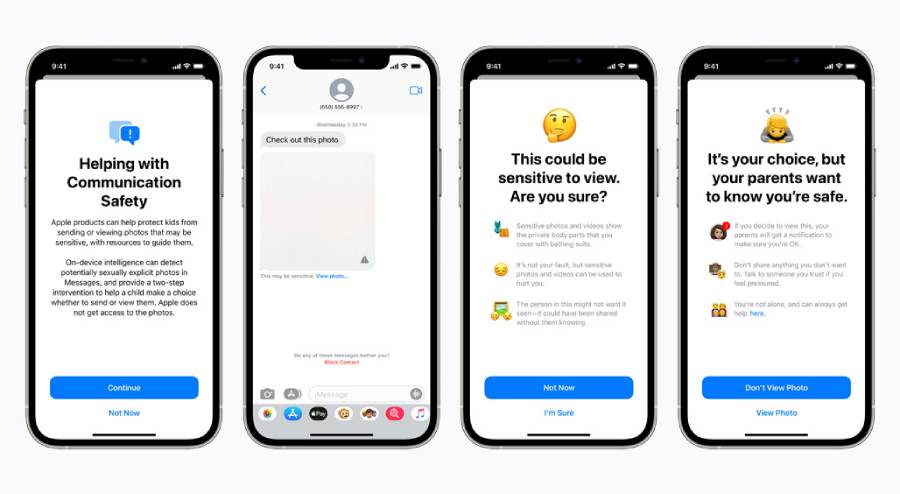

นอกจากนี้มันยังสามารถตรวจสอบข้อความบน Messages หากมีการส่งข้อความหรือภาพในทางอนาจารไปยัง iPhone หรือ iPad ของผู้เยาว์ โดยระบบจะทำการเซ็นเซอร์ภาพเหล่านั้นเอาไว้ก่อน และจะมีการถามว่าคุณต้องเปิดดูภาพดังกล่าวจริงหรือไม่ ซึ่งถ้าเด็ก ๆ ตอบตกลงก็จะมีการส่งการแจ้งเตือนไปยังผู้ปกครองทันที

นักวิจัยด้านความปลอดภัยกล่าวว่าเทคโนโลยีดังกล่าวของ Apple อาจถูกนำมาใช้ในด้านอื่น ๆ ที่อาจมีผลกระทบทางการเมืองและความปลอดภัยของผู้ใช้ได้ แต่ในตอนนี้มันถือว่ามีประโยชน์ในการคุ้มครองเด็ก ๆ จากการถูกทารุณกรรมได้

ที่มา macrumors