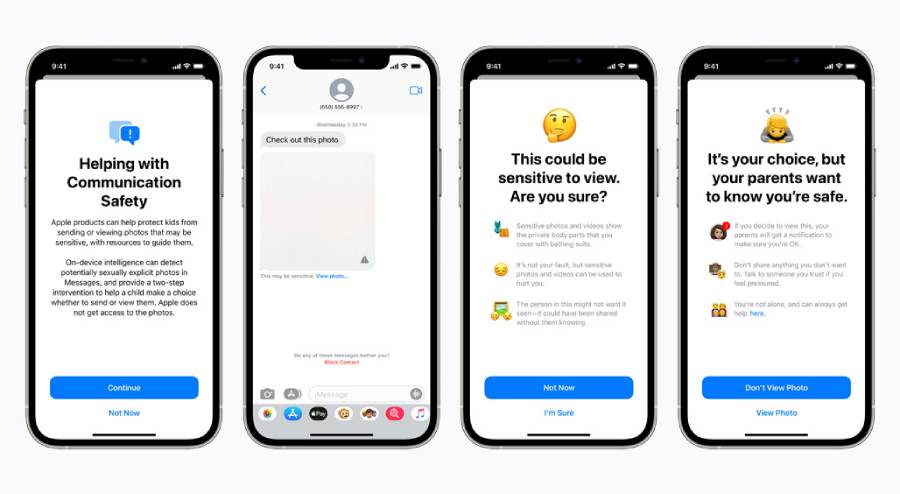

ก่อนหน้านี้ Apple จะเปิดตัวฟีเจอร์ CSAM Detection ที่จะตรวจเช็คภาพโป๊ของเด็ก บน iCloud รวมไปถึงฟีเจอร์ความปลอดภัย และป้องกันการละเมิดทางเพศกับเด็ก จนเกิดเป็นประเด็นถกเถียงกันขึ้นมาในโลกออนไลน์ ทำให้ล่าสุดบริษัทต้องออกมาประกาศว่าจะเลื่อนการเปิดตัวฟีเจอร์ดังกล่าวออกไปก่อน

Apple กล่าวว่า “เมื่อเดือนที่แล้วเราได้ประกาศแแผนการที่จะเปิดตัวฟีเจอร์ที่มุ้งเน้นไปที่การปกป้องเด็กๆ จากเหล่านักล่าที่ใช้สมาร์ทโฟนเป็นเครื่องมือในการล่วงละเมิดทางเพศเด็ก แต่จากผลตอบรับของลูกค้า, กลุ่มผู้สนับสนุน, นักวิจัยและคนอื่นๆ ทำให้เราตัดสินใจที่จะเลื่อนการเปิดตัวฟีเจอร์ออกไปก่อน เพื่อรวบรวมข้อมูลและปรับปรุงฟีเจอร์ให้เหมาะสมก่อนที่จะเปิดตัวอย่างเป็นทางการ”

โดยก่อนหน้านี้ตัวฟีเจอร์ดังกล่าวมีแผนที่จะเปิดตัวพร้อมกับการอัปเดต iOS 15, iPadOS 15 และ macOS Monterey ในช่วงปลายปีนี้ แต่ตอนนี้บริษัทยังไม่ได้ยืนยันว่าตัวฟีเจอร์จะถูกเลื่อนไปจนถึงเมื่อไหร่

ที่มา 9to5mac